얼마 전 미국 애리조나에서 시험운행증이었던 우버 자율주행차가 교차로에서 길을 건너던 보행자를 치다가 보행자가 사망하는 사고가 발생했습니다.

<그림1> 사고 당시의 현장 사진(출처: ABC)

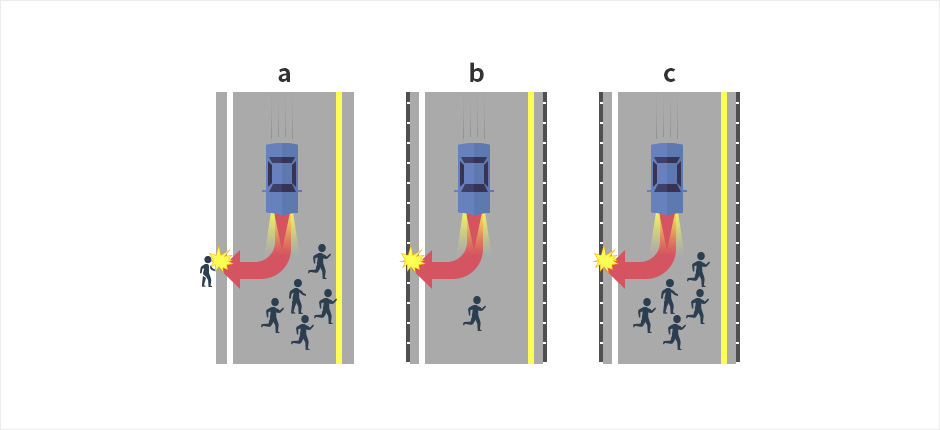

이번 자율주행차 사망사고는 자율주행차 개발업체뿐만 아니라 자율주행차 대중화에 관심을 가졌던 많은 이들에게도 큰 충격을 주는 사건이었습니다. 특히 이번 사고로 자율주행차의 안전성, 법적 책임, 윤리적·도덕적 문제 등에 관해 많은 논의가 이뤄지게 됐습니다. 이번 블로그에서는 자율주행차와 관련해 어떤 윤리적 문제가 있는지, 윤리적 문제를 해결하기 위해 어떤 노력을 기울이고 있는지에 대해 생각해보는 시간을 갖고자 합니다.

<그림 2> 트롤리 딜레마(출처: “Would You Kill the Fat Man?”, 프리스톤대학 출판사)

<그림 2>에서 보시는 것처럼 전동차는 운행 중 이상이 생겨 제어 불능 상태가 되었습니다. 이대로라면 5명이 전철에 치여 죽을 위기에 처해 있습니다. 마침 저는 전철 선로를 변경할 수 있는 위치에 있습니다만, 선로를 변경하면 다른 선로의 1명이 전철에 치여 죽고 맙니다. 양쪽 모두 피난할 시간이 없는 경우, 저는 어떤 결정을 내려야 할까요?이 시험은 영국의 윤리철학자 필리파 풋이 처음 제시한 ‘트롤리 딜레마(Trolley Problem)’라는 윤리학 시험 중 하나입니다. 법적 책임을 지지 않는다고 가정했을 때, 본인이라면 어떤 결정을 내릴까요? 개인의 신념이나 이념 혹은 본능에 따라 결정을 내릴 것입니다. 물론 그 결정이 반드시 올바른 결정이라고는 할 수 없지만요.

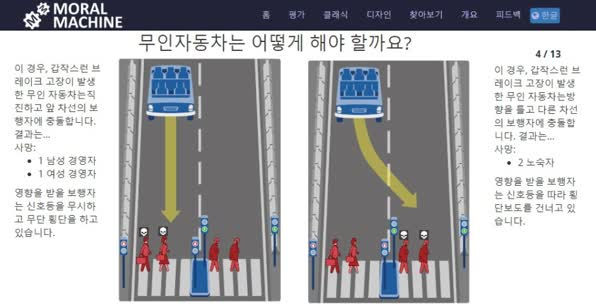

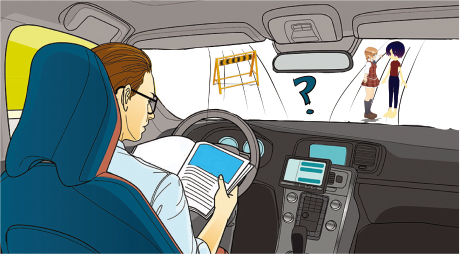

<그림3> 자율주행차의 윤리적 딜레마(출처: ‘The EHICAL DILEMMA OF SELF-DRIVING CARS’, YouTube)

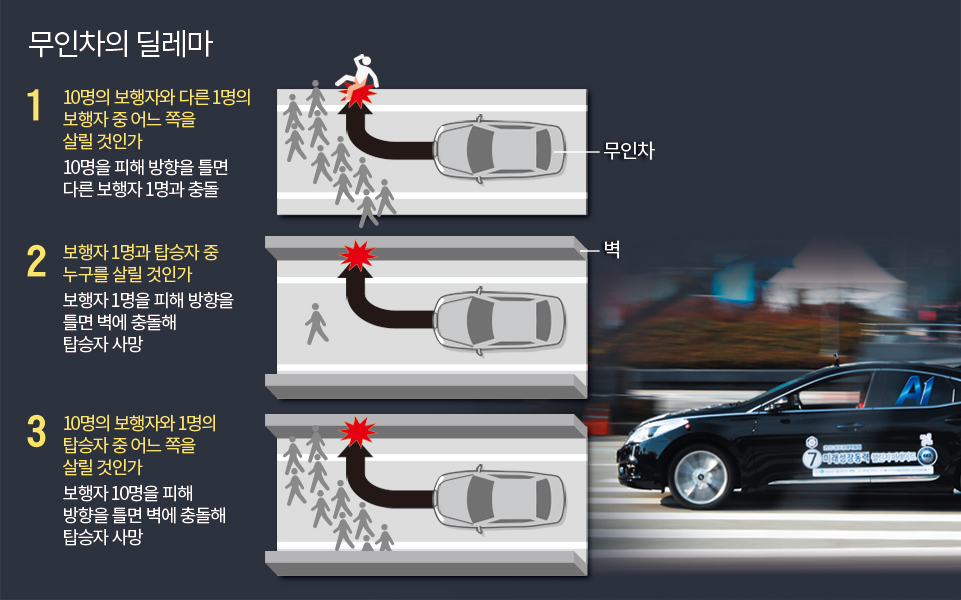

이번에는 개인이 아닌 자동 운전 차에 상황을 대입하고 보겠습니다.<그림 3>에서 보듯 고속 도로를 자동차 운전 차가 정면에 트럭에 부딪치는 위기에 처했습니다.왼쪽에는 딱딱한 SUV, 오른쪽에는 오토바이가 함께 달리고 있습니다.이 때, 자동 운전 차는3가지 방법을 선택할 수 있습니다.1)정면의 트럭과 충돌하면서 내가 큰 피해를 받는다.2) 튼튼한 SUV로 방향을 바꾸고 차만이 큰 피해를 받는다.3)오른쪽의 오토바이로 방향을 바꾸고 자신의 차는 큰 피해를 받지 않지만 남에게 큰 피해를 준다.이번 경우는 방금 설명한 트롤리 딜레마라는 좀 상황이 다릅니다.바로 결정권이 내가 아닌 자동 운전 차에 있어요.즉 자신이 피해를 받거나 남이 피해를 보느냐의 결정은 자신의 신념, 이념, 본능이 아니라 자동 운전 차 업체의 알고리즘에 의해서 결정된다는 것입니다.만약 위의 상황에서 알고리즘의 결정이 나의 생각한 결정과 다른 경우가 생기면 어떻게 될까요?이건 나중에 법적 쟁점으로까지 이어질 수 있는 큰 문제죠.그래서”자동 운전의 주체는 누구인가?”,”알고리즘의 통제는 정부가 해야 하는가?”,”자동 운전 범위를 운전자가 지정할 수 있는가?”등의 문제는 반드시 해결해야 할 문제가 되었습니다.이를 해결하기 위해서 독일 정부는 지난해 인간 생명의 보호를 최우선으로 한다는 자동 운전 차 윤리 가이드 라인을 선 보이며 구글은 인공 지능이 훈련을 통해서 학습된 데이터가 잘 대변되도록 신경을 쓰겠다고 입장을 밝혔습니다.국내에서도 자동 운전 차 윤리 세미나를 여는 등 노력을 기울이고는 있습니다.그러나 이는 일반적인 사실을 확인할 뿐 근본적인 문제 해결 방법은 없는 상태입니다.자동 운전 차량의 대중화는 먼 미래의 일이 아니잖아요.그러나 갈수록 급성장하는 기술의 발전에 비하면 윤리적 문제는 아직 갈 길이 멀어요.지금이라도 사회적 협의나 강력한 지침 등을 통해서 윤리적 문제를 해결하는 모습을 기대하고 보면 어떨까요?물론 선악이 없는 문제에서 올바름을 찾기는 어려운 일이죠?참고 자료:World Economic Forum,”German has developed a set of ethical guidelines for self-driving cars”Patrick Lin,”The ETHICAL DILEMMA OF SELF-DRIVING CARS”

![[수입차 중고부품] 골프 7세대차 앞/후방 추돌 사고! 보닛 범퍼 그릴 백도어 그릴 테일 라이트 레일 전판넬 펜더 부품을 저렴한 중고 부품으로 대체하고 합리적인 비용으로 수리해보자! [수입차 중고부품] 골프 7세대차 앞/후방 추돌 사고! 보닛 범퍼 그릴 백도어 그릴 테일 라이트 레일 전판넬 펜더 부품을 저렴한 중고 부품으로 대체하고 합리적인 비용으로 수리해보자!](https://web.joongna.com/cafe-article-data/live/2024/09/04/1074956179/1725410453554_000_JnUvN_main.png)

![[아이엘츠과제] 자율 주행 자동차(Driverless car), 원리, 장점, 단점, 단계별 수준 [Cambridge IELTS 15] [아이엘츠과제] 자율 주행 자동차(Driverless car), 원리, 장점, 단점, 단계별 수준 [Cambridge IELTS 15]](https://blog.kakaocdn.net/dn/bj7jeg/btq3PBcbCXk/hBvPNgu28bTkGApB7qIcO1/img.png)